| 失效链接处理 |

|

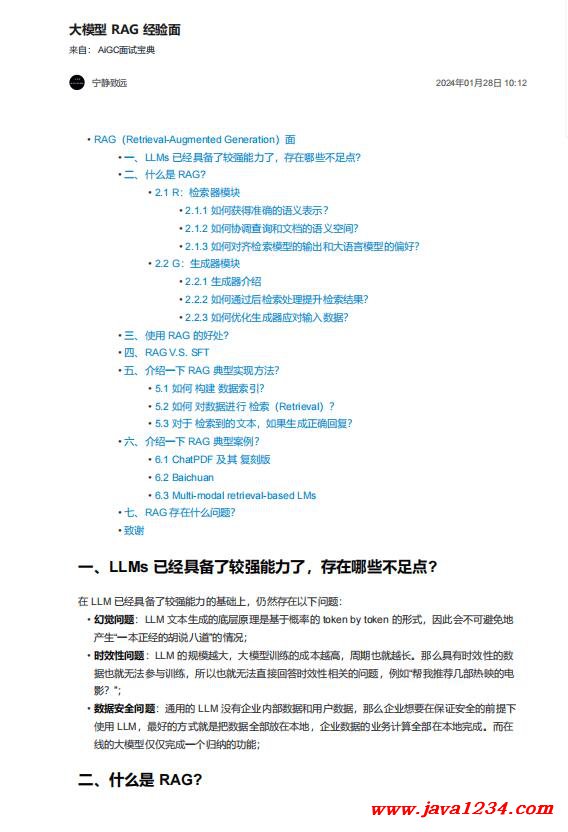

大模型 RAG 经验面 PDF 下载

相关截图:

主要内容:

一、LLMs 已经具备了较强能力了,存在哪些不足点?

在 LLM 已经具备了较强能力的基础上,仍然存在以下问题:

• 幻觉问题:LLM 文本生成的底层原理是基于概率的 token by token 的形式,因此会不可避免地

产生“一本正经的胡说八道”的情况;

• 时效性问题:LLM 的规模越大,大模型训练的成本越高,周期也就越长。那么具有时效性的数

据也就无法参与训练,所以也就无法直接回答时效性相关的问题,例如“帮我推荐几部热映的电

影?”;

• 数据安全问题:通用的 LLM 没有企业内部数据和用户数据,那么企业想要在保证安全的前提下

使用 LLM,最好的方式就是把数据全部放在本地,企业数据的业务计算全部在本地完成。而在

线的大模型仅仅完成一个归纳的功能

二、什么是 RAG?

RAG(Retrieval Augmented Generation, 检索增强生成),即 LLM 在回答问题或生成文本时,先

会从大量文档中检索出相关的信息,然后基于这些信息生成回答或文本,从而提高预测质量。

2.1 R:检索器模块

在 RAG技术中,“R”代表检索,其作用是从大量知识库中检索出最相关的前 k 个文档。然而,构建

一个高质量的检索器是一项挑战。研究探讨了三个关键问题:

2.1.1 如何获得准确的语义表示?

在 RAG 中,语义空间指的是查询和文档被映射的多维空间。以下是两种构建准确语义空间的方

法。

1. 块优化

处理外部文档的第一步是分块,以获得更细致的特征。接着,这些文档块被嵌入。

选择分块策略时,需要考虑被索引内容的特点、使用的嵌入模型及其最适块大小、用户查询的预期

长度和复杂度、以及检索结果在特定应用中的使用方式。实际上,准确的查询结果是通过灵活应用

多种分块策略来实现的,并没有最佳策略,只有最适合的策略。

1. 微调嵌入模型

在确定了 Chunk 的适当大小之后,我们需要通过一个嵌入模型将 Chunk 和查询嵌入到语义空间

中。如今,一些出色的嵌入模型已经问世,例如 UAE、Voyage、BGE等,它们在大规模语料库上

预训练过

|

苏公网安备 32061202001004号

苏公网安备 32061202001004号