| 失效链接处理 |

|

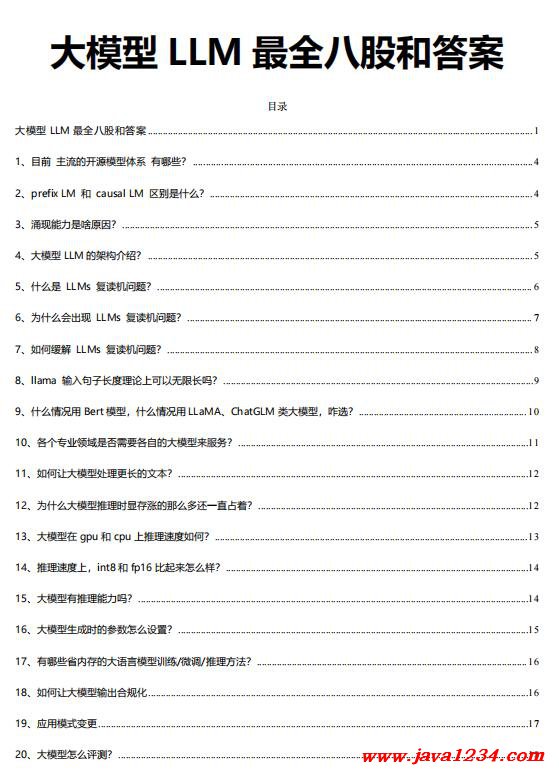

大模型 LLM 最全八股和答案 PDF 下载

相关截图:

主要内容:

2、prefix LM 和 causal LM 区别是什么?

Prefix LM(前缀语言模型)和 Causal LM(因果语言模型)是两种不同类型的语言模型,它们的区

别在于生成文本的方式和训练目标。

1.

Prefix LM:前缀语言模型是一种生成模型,它在生成每个词时都可以考虑之前的上下文信息。在生成时,

前缀语言模型会根据给定的前缀(即部分文本序列)预测下一个可能的词。这种模型可以用于文本生成、机器翻译

等任务。

2.

Causal LM:因果语言模型是一种自回归模型,它只能根据之前的文本生成后续的文本,而不能根据后续的

文本生成之前的文本。在训练时,因果语言模型的目标是预测下一个词的概率,给定之前的所有词作为上下文。这

种模型可以用于文本生成、语言建模等任务。

总结来说,前缀语言模型可以根据给定的前缀生成后续的文本,而因果语言模型只能根据之前的文本

生成后续的文本。它们的训练目标和生成方式略有不同,适用于不同的任务和应用场景。

3、涌现能力是啥原因?

大模型的涌现能力主要是由以下几个原因造成的:

1.

数据量的增加:随着互联网的发展和数字化信息的爆炸增长,可用于训练模型的数据量大大增加。更多的

数据可以提供更丰富、更广泛的语言知识和语境,使得模型能够更好地理解和生成文本。

2.

计算能力的提升:随着计算硬件的发展,特别是图形处理器(GPU)和专用的 AI 芯片(如 TPU)的出现,

计算能力大幅提升。这使得训练更大、更复杂的模型成为可能,从而提高了模型的性能和涌现能力。

3.

模型架构的改进:近年来,一些新的模型架构被引入,如 Transformer,它在处理序列数据上表现出色。

这些新的架构通过引入自注意力机制等技术,使得模型能够更好地捕捉长距离的依赖关系和语言结构,提高了模型

的表达能力和生成能力。

|

苏公网安备 32061202001004号

苏公网安备 32061202001004号