| 失效链接处理 |

|

Transformer面试 DOC 下载

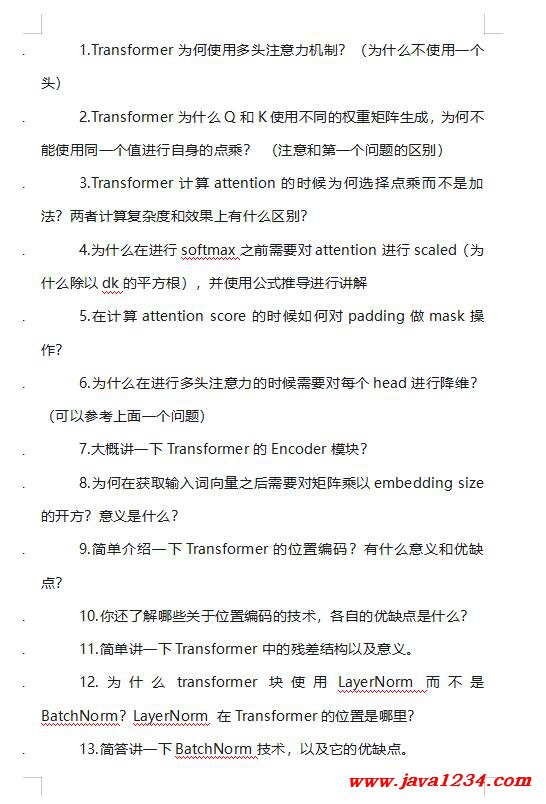

相关截图:

主要内容:

.1.Transformer为何使用多头注意力机制?(为什么不使用一个头)

|

| SpringBoot+SpringSecurity+Vue+ElementPlus权限系统实战课程 震撼发布 |

最新Java全栈就业实战课程(免费)AI人工智能学习大礼包IDEA永久激活 |

66套java实战课程无套路领取锋哥开始收Java学员啦!Python学习路线图 |

| 失效链接处理 |

|

Transformer面试 DOC 下载

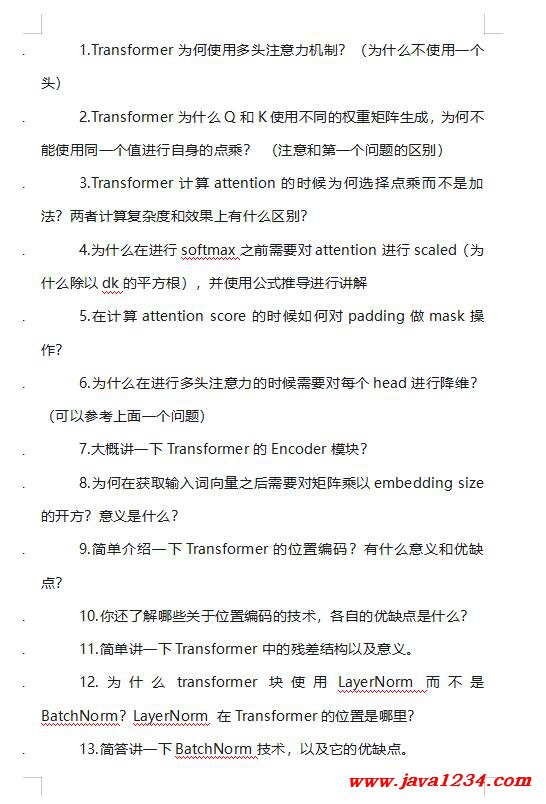

相关截图:

主要内容:

.1.Transformer为何使用多头注意力机制?(为什么不使用一个头)

|

锋哥推荐