| 失效链接处理 |

|

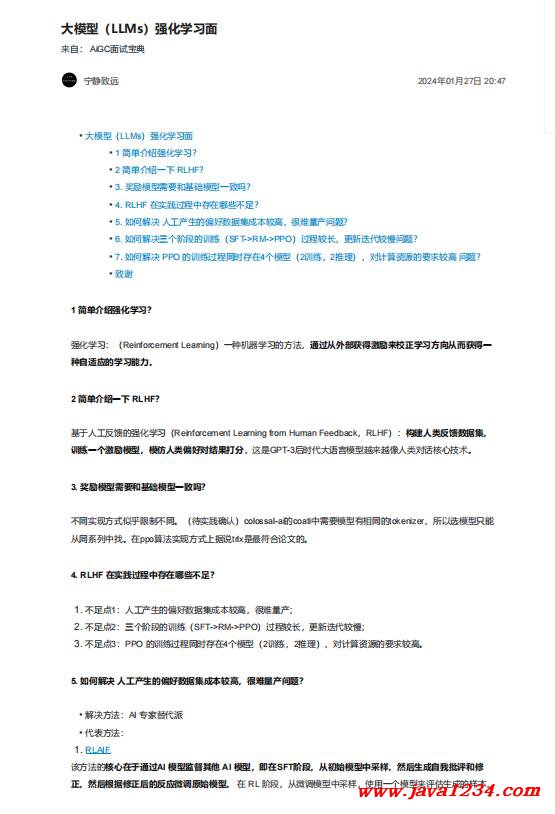

大模型(LLMs)强化学习面 PDF 下载

相关截图:

主要内容:

1 简单介绍强化学习?

强化学习:(Reinforcement Learning)一种机器学习的方法,通过从外部获得激励来校正学习方向从而获得一

种自适应的学习能力。

2 简单介绍一下 RLHF?

基于人工反馈的强化学习(Reinforcement Learning from Human Feedback,RLHF):构建人类反馈数据集,

训练一个激励模型,模仿人类偏好对结果打分,这是GPT-3后时代大语言模型越来越像人类对话核心技术。

3. 奖励模型需要和基础模型一致吗?

不同实现方式似乎限制不同。(待实践确认)colossal-ai的coati中需要模型有相同的tokenizer,所以选模型只能

从同系列中找。在ppo算法实现方式上据说trlx是最符合论文的。

4. RLHF 在实践过程中存在哪些不足?

1. 不足点1:人工产生的偏好数据集成本较高,很难量产;

2. 不足点2:三个阶段的训练(SFT->RM->PPO)过程较长,更新迭代较慢;

3. 不足点3:PPO 的训练过程同时存在4个模型(2训练,2推理),对计算资源的要求较高。

5. 如何解决 人工产生的偏好数据集成本较高,很难量产问题?

该方法的核心在于通过AI 模型监督其他 AI 模型,即在SFT阶段,从初始模型中采样,然后生成自我批评和修

正,然后根据修正后的反应微调原始模型。 在 RL 阶段,从微调模型中采样,使用一个模型来评估生成的样本,

|

苏公网安备 32061202001004号

苏公网安备 32061202001004号