| 失效链接处理 |

|

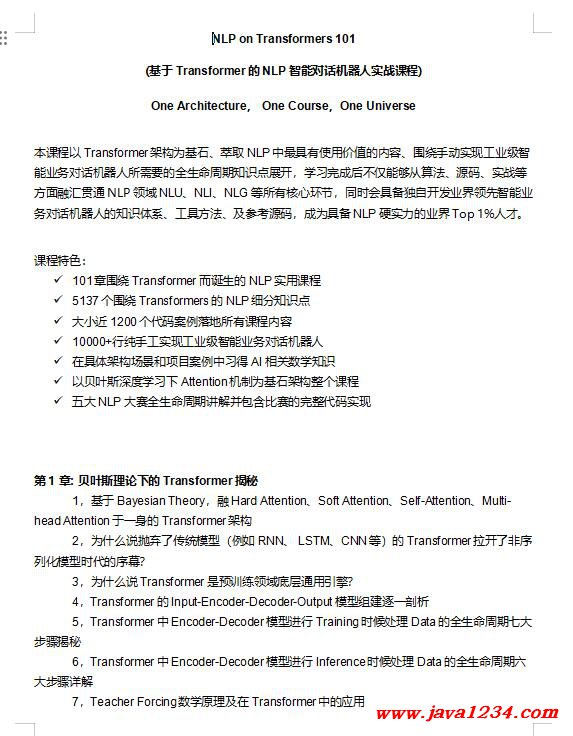

NLP+on+Transformer面试题 DOC 下载

相关截图:

主要内容: 第1章: 贝叶斯理论下的Transformer揭秘 1,基于Bayesian Theory,融Hard Attention、Soft Attention、Self-Attention、Multi-head Attention于一身的Transformer架构 2,为什么说抛弃了传统模型(例如RNN、 LSTM、CNN等)的Transformer拉开了非序列化模型时代的序幕? 3,为什么说Transformer是预训练领域底层通用引擎? 4,Transformer的Input-Encoder-Decoder-Output模型组建逐一剖析 5,Transformer中Encoder-Decoder模型进行Training时候处理Data的全生命周期七大步骤揭秘 6,Transformer中Encoder-Decoder模型进行Inference时候处理Data的全生命周期六大步骤详解 7,Teacher Forcing数学原理及在Transformer中的应用

|

苏公网安备 32061202001004号

苏公网安备 32061202001004号