| 失效链接处理 |

|

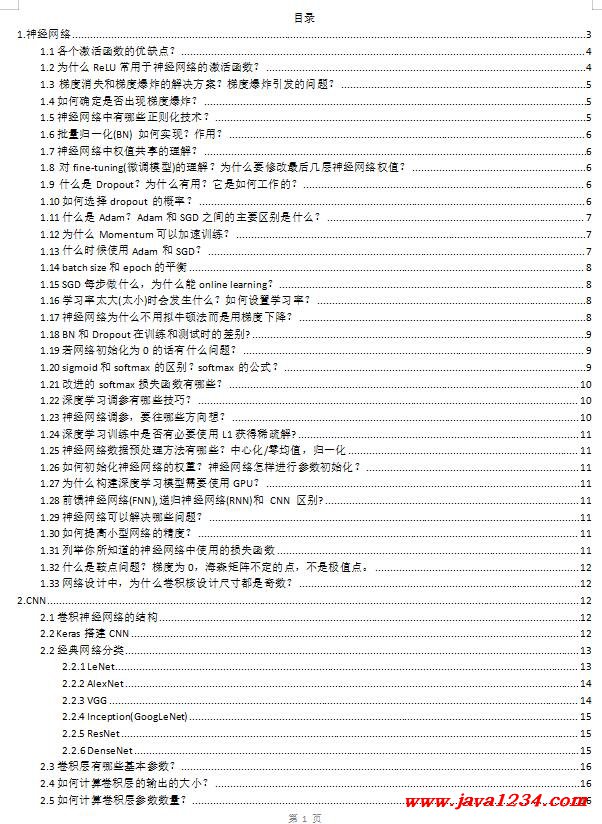

卷积神经网络面试题 DOC 下载

相关截图:

主要内容: 1.2为什么ReLU常用于神经网络的激活函数? 1.在前向传播和反向传播过程中,ReLU相比于Sigmoid等激活函数计算量小; 2.避免梯度消失问题。对于深层网络,Sigmoid函数反向传播时,很容易就会出现梯度消失问题(在Sigmoid接近饱和区时,变换太缓慢,导数趋于0,这种情况会造成信息丢失),从而无法完成深层网络的训练。

3.可以缓解过拟合问题的发生。Relu会使一部分神经元的输出为0,这样就造成了网络的稀疏性,并且减少了参数的相互依存关系,缓解了过拟合问题的发生。 4.相比Sigmoid型函数,ReLU函数有助于随机梯度下降方法收敛。 为什么需要激活功能? 激活函数是用来加入非线性因素的,因为线性模型的表达能力不够。

1.3 梯度消失和梯度爆炸的解决方案?梯度爆炸引发的问题? 梯度消失:靠近输出层的hidden layer 梯度大,参数更新快,所以很快就会收敛; 而靠近输入层的hidden layer 梯度小,参数更新慢,几乎就和初始状态一样,随机分布。 另一种解释:当反向传播进行很多层的时候,由于每一层都对前一层梯度乘以了一个小数,因此越往前传递,梯度就会越小,训练越慢。 梯度爆炸:前面layer的梯度通过训练变大,而后面layer的梯度指数级增大。 ①在深度多层感知机(MLP)网络中,梯度爆炸会引起网络不稳定,最好的结果是无法从训练数据中学习,而最坏的结果是出现无法再更新的 NaN 权重值。 ②在RNN中,梯度爆炸会导致网络不稳定,无法利用训练数据学习,最好的结果是网络无法学习长的输入序列数据。

|

苏公网安备 32061202001004号

苏公网安备 32061202001004号