| 失效链接处理 |

|

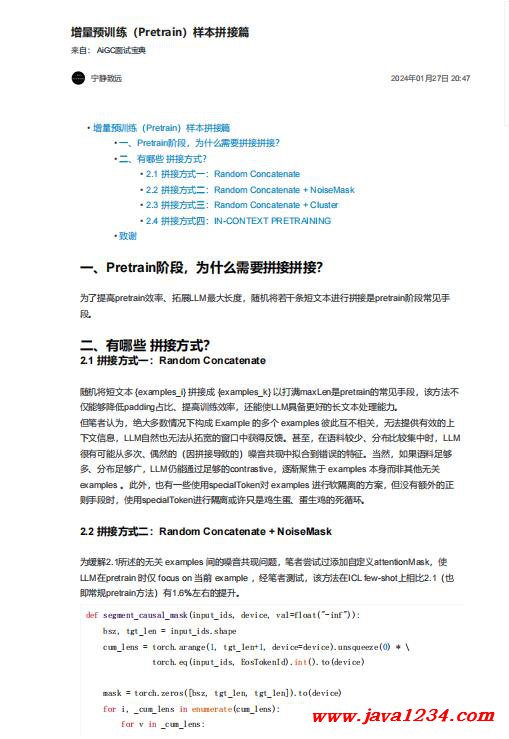

增量预训练(Pretrain)样本拼接篇 PDF 下载

相关截图:

主要内容:

一、Pretrain阶段,为什么需要拼接拼接?

为了提高pretrain效率、拓展LLM最大长度,随机将若干条短文本进行拼接是pretrain阶段常见手

段。

二、有哪些 拼接方式?

2.1 拼接方式一:Random Concatenate

随机将短文本 {examples_i} 拼接成 {examples_k} 以打满maxLen是pretrain的常见手段,该方法不

仅能够降低padding占比、提高训练效率,还能使LLM具备更好的长文本处理能力。

但笔者认为,绝大多数情况下构成 Example 的多个 examples 彼此互不相关,无法提供有效的上

下文信息,LLM自然也无法从拓宽的窗口中获得反馈。甚至,在语料较少、分布比较集中时,LLM

很有可能从多次、偶然的(因拼接导致的)噪音共现中拟合到错误的特征。当然,如果语料足够

多、分布足够广,LLM仍能通过足够的contrastive,逐渐聚焦于 examples 本身而非其他无关

examples 。此外,也有一些使用specialToken对 examples 进行软隔离的方案,但没有额外的正

则手段时,使用specialToken进行隔离或许只是鸡生蛋、蛋生鸡的死循环。

|

苏公网安备 32061202001004号

苏公网安备 32061202001004号