| 失效链接处理 |

|

spark知识点整理 PDF 下载

本站整理下载:

提取码:q5kn

相关截图:

主要内容:

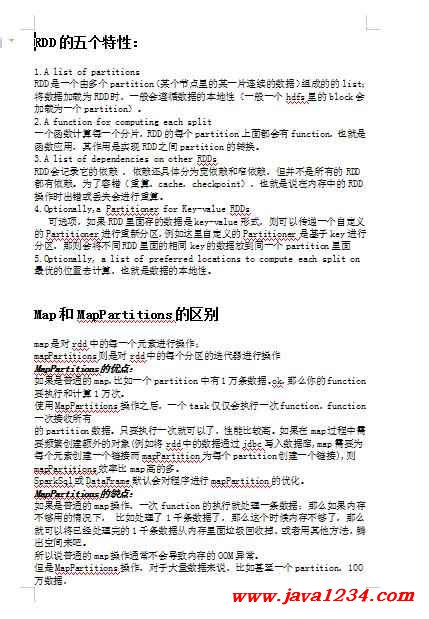

RDD的五个特性:

1.A list of partitions

RDD是一个由多个partition(某个节点里的某一片连续的数据)组成的的list;将数据加载为RDD时,一般会遵循数据的本地性(一般一个hdfs里的block会加载为一个partition)。

2.A function for computing each split

一个函数计算每一个分片,RDD的每个partition上面都会有function,也就是函数应用,其作用是实现RDD之间partition的转换。

3.A list of dependencies on other RDDs

RDD会记录它的依赖 ,依赖还具体分为宽依赖和窄依赖,但并不是所有的RDD都有依赖。为了容错(重算,cache,checkpoint),也就是说在内存中的RDD操作时出错或丢失会进行重算。

4.Optionally,a Partitioner for Key-value RDDs

可选项,如果RDD里面存的数据是key-value形式,则可以传递一个自定义的Partitioner进行重新分区,例如这里自定义的Partitioner是基于key进行分区,那则会将不同RDD里面的相同key的数据放到同一个partition里面

5.Optionally, a list of preferred locations to compute each split on

最优的位置去计算,也就是数据的本地性。

Map和MapPartitions的区别

map是对rdd中的每一个元素进行操作;

mapPartitions则是对rdd中的每个分区的迭代器进行操作

MapPartitions的优点:

如果是普通的map,比如一个partition中有1万条数据。ok,那么你的function要执行和计算1万次。

使用MapPartitions操作之后,一个task仅仅会执行一次function,function一次接收所有

的partition数据。只要执行一次就可以了,性能比较高。如果在map过程中需要频繁创建额外的对象(例如将rdd中的数据通过jdbc写入数据库,map需要为每个元素创建一个链接而mapPartition为每个partition创建一个链接),则mapPartitions效率比map高的多。

SparkSql或DataFrame默认会对程序进行mapPartition的优化。

MapPartitions的缺点:

如果是普通的map操作,一次function的执行就处理一条数据;那么如果内存不够用的情况下, 比如处理了1千条数据了,那么这个时候内存不够了,那么就可以将已经处理完的1千条数据从内存里面垃圾回收掉,或者用其他方法,腾出空间来吧。

所以说普通的map操作通常不会导致内存的OOM异常。

但是MapPartitions操作,对于大量数据来说,比如甚至一个partition,100万数据,

一次传入一个function以后,那么可能一下子内存不够,但是又没有办法去腾出内存空间来,可能就OOM,内存溢出。

宽依赖、窄依赖

窄依赖:父RDD的每个分区只能被一个子RDD分区使用(1对1或者 多对1)

宽依赖:父RDD的每个分区都可能被多个子RDD分区使用(1对多)。

一些常见的宽窄依赖

窄依赖:map、filter、union、mapPartitions、join(当分区器是HashPartitioner)

宽依赖:sortByKey、join(分区器不是HashPartitioner时)

reduceByKey 是宽依赖还是窄依赖 ?/todo

https://www.cnblogs.com/upupfeng/p/12344963.html

https://github.com/rohgar/scala-spark-4/wiki/Wide-vs-Narrow-Dependencies

https://blog.csdn.net/qq_34993631/article/details/88890669

partition数量由什么决定

https://blog.csdn.net/thriving_fcl/article/details/78072479

spark并行度

spark.sql.shuffle.partitions 默认值是200, 是返回的 RDD s中的默认分区数通过 join , reduceByKey 和 parallelize 等转换由用户明确设置。请注意, spark.default.parallelism 似乎只适用于原始 RDD ,并在处理数据帧时被忽略。

spark.default.parallelism 非sparksql中使用, 配置混洗连接或聚合数据时使用的分区数。

https://www.jianshu.com/p/e721f002136c

spark共享变量

在应用开发中,一个函数被传递给Spark操作(例如map和reduce),在一个远程集群上运行,它实际上操作的是这个函数用到的所有变量的独立拷贝。这些变量会被拷贝到每一台机器。通常看来,在任务之间中,读写共享变量显然不够高效。然而,Spark还是为两种常见的使用模式,提供了两种有限的共享变量:广播变量和累加器。

(1). 广播变量(Broadcast Variables)

– 广播变量缓存到各个节点的内存中,而不是每个 Task

– 广播变量被创建后,能在集群中运行的任何函数调用

|

苏公网安备 32061202001004号

苏公网安备 32061202001004号