| 失效链接处理 |

|

Apache Hive 中文手册 PDF 下载

本站整理下载:

提取码:34sp

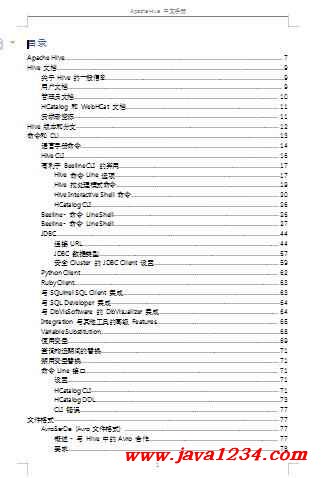

相关截图:

主要内容:

Apache Hive

在标题为“Information Platforms and the Rise of the Data Scientist”的文章一文中,Jeff Hammerbacher把“信息平台”描述为“企业摄取(ingest)、处理(process)、生成(generate)信息的行为”与“帮助加速从经验数据中学习”的“中心”。

在Facebook,Jeff团队所构建的信息平台中,最庞大的组成部分是Apache Hive(https://hive.apache.org/)。Hive是一个构建在Hadoop上的数据仓库框架,是应Facebook每天产生的海量新兴社会网络数据进行管理和(机器)学习的需求而产生和发展的。在尝试了不同系统之后,Jeff团队选择Hadoop来存储和处理数据,因为Hadoop的性价比高,同时还能够满足他们的可伸缩性要求。

Hive的设计目的是让精通SQL技能但Java编程技能相对较弱的分析师能够对Facebook存放在HDFS中的大规模数据集执行查询。今天,Hive已经是一个成功的Apache项目,很多组织把它用作一个通用的、可伸缩的数据处理平台。

当然,SQL并不是所有大数据问题的理想工具。例如,它并不适合用来开发复杂的机器学习算法。但它对很多分析任务非常有用,而且它的另一个优势是业内人士都非常熟悉它。此外,SQL是商业智能工具的“通用语言”(可以通过ODBC这一桥梁来用),Hive有条件和这些产品进行集成。

最早提出“数据科学家”这个头衔的人,也是Facebook数据科学团队的负责人,Cloudera的联合创始人。这位出生于1983年的数学天才有一句名言:“我们这一代最杰出的头脑都在拼命思考如何吸引人们点击更多的广告,这个感觉糟透了。”他后来加入纽约著名的西奈山医院,成为一位医学研究者,运用自己的数据分析才能去攻克癌症、老年痴呆症、糖尿病及其他慢性疾病。

本章介绍如何使用Hive。我们假设你用过SQL和常见的数据库体系结构。在介绍Hive特性的同时,我们会经常将这些特性与其传统RDBMS对应部分进行比较。

Apache Hive™数据仓库软件有助于读取,编写和管理驻留在分布式存储中的大型数据集,并使用 SQL 语法进行查询。

构建于Apache Hadoop™之上,Hive 提供以下特性:

o通过 SQL 轻松访问数据的工具,从而实现数据仓库任务,如 extract/transform/load(ETL),报告和数据分析。

o一种在各种数据格式上强加结构的机制

o访问 files 直接存储在Apache HDFS™或其他数据存储系统中,例如Apache HBase™

o通过Apache Tez ™,Apache Spark™或MapReduce执行查询

o程序语言 HPL-SQL

oSub-second 通过Hive LLAP,Apache YARN和Apache Slider进行查询检索。

Hive 提供标准的 SQL 功能,包括许多后来的SQL:2003,SQL:2011和SQL:2016 features 用于分析。

Hive 的 SQL 也可以通过用户定义函数(UDF),用户定义聚合(UDAF)和用户定义的 table 函数(UDTF)与用户 code 一起扩展。

没有一个“Hive 格式”必须存储数据。 Hive 附带内置连接器,用于逗号和 tab-separated 值(CSV/TSV)文本文件,Apache 实木复合地板 ™,Apache ORC™和其他格式。用户可以使用其他格式的连接器扩展 Hive。有关详细信息,请参阅开发者指南中的文件格式和Hive SerDe。

Hive 不是为在线 transaction 处理(OLTP)工作负载而设计的。它最适用于传统的数据仓库任务。

Hive 旨在通过其输入格式最大化可扩展性(使用动态添加到 Hadoop cluster 的更多机器扩展),performance,extensibility,fault-tolerance 和 loose-coupling。

Hive 的组件包括 HCatalog 和 WebHCat。

oHCatalog是 Hadoop 的 table 和存储管理层,使用户可以使用不同的数据处理工具(包括 Pig 和 MapReduce)更轻松地在网格上读写数据。

oWebHCat提供的服务可用于运行 Hadoop MapReduce(或 YARN),Pig,Hive 作业。您还可以使用 HTTP(REST 样式)接口执行 Hive 元数据操作。

|

苏公网安备 32061202001004号

苏公网安备 32061202001004号